作为一个程序员,对于AI项目我一直有关注,关于声音克隆从SoVITS到Bert-VITS也都用过,但都没有推荐分享过,有些虽然已经复刻的很完美,但推理多了,总有瑕疵,在试用了GPT-SoVITS项目后,我觉得这个效果可以做终极解决方案了,再优化也就是操作上与一些细节,克隆的声音已接近完美。

首先下载一键整合包:https://pan.quark.cn/s/e5365f0ef245

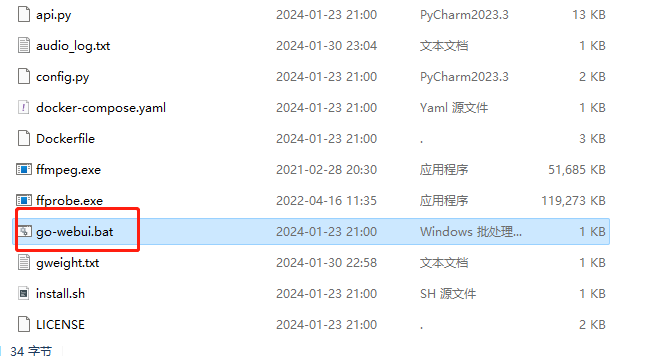

下载后解压,双击go-webui.bat文件启动,等待一会

第一次启动会有点慢,启动后会自动打开你的浏览器

首页就是这样的,其它的不用管,我们直接上传要克隆的音频,时长最好在一分钟以上,多了也没事

我这里用某真的演讲进行测试,各位比较熟悉的声音,这样大家最后直接看效果即可

如果你的原始音频有杂音,可以点击降噪处理,如果比较清楚,就直接切割音频。

这里注意,如果你之前复刻过一个声音,这里是复刻另一个人声音的话,在切割前需要把output/slicer_opt文件夹清空

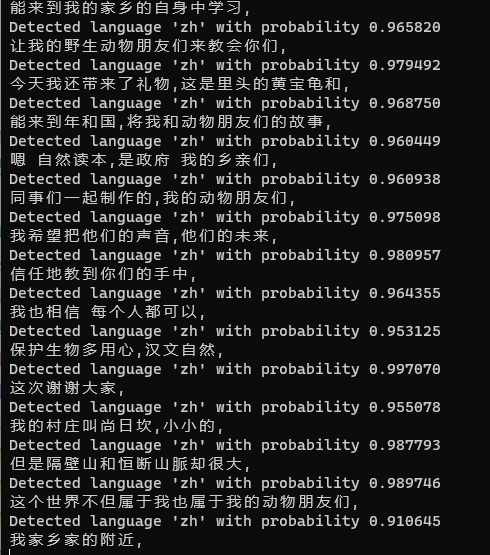

切割结束我们点击下面的【开启Faster-Whisper离线ASR】按钮,这一步是对音频进行识别与标注,中英日都可自动识别

音频打标进度可以在控制台查看,完成后在ASR进程输出信息中会显示

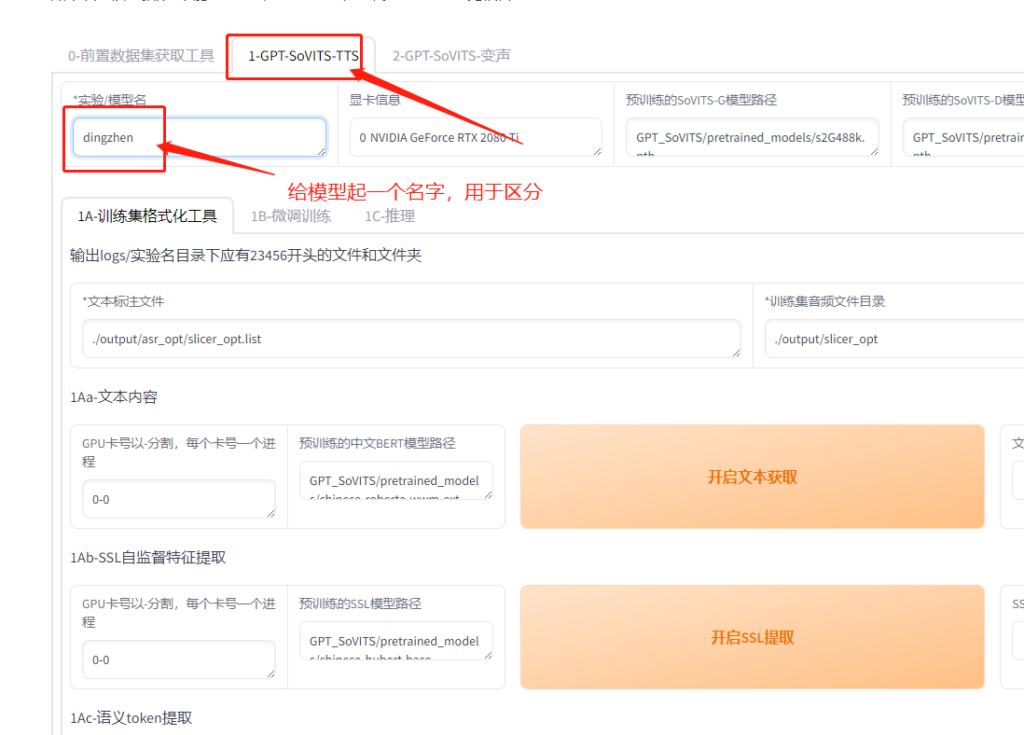

ASR完成后,直接点击上方菜单GPT-SoVITS-TTS进入训练页面

这里给模型起个名字后,拉到页面最下面,点击【开启一键三连】进行训练集格式化

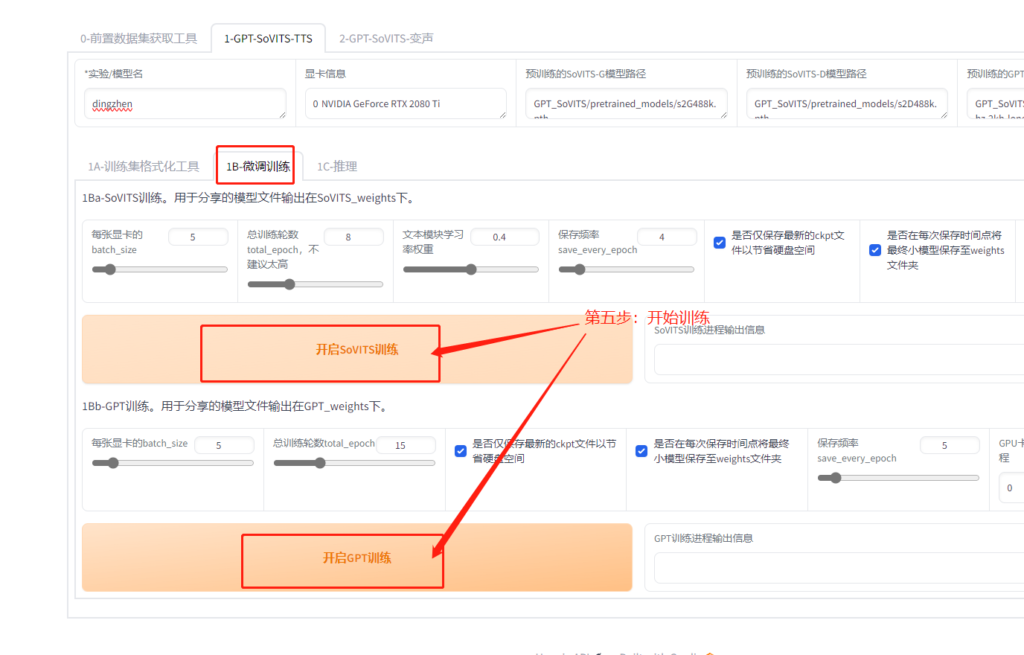

等待进程结束后,进行模型训练,点击微调训练

两个训练都进行一下,如果你的显卡比较好,可以将batch_size调高,测试是12G显存调8没问题,训练结束它自己会在进程框中显示。

训练完成后点击推理标签,这个页面其它不用管,直接选择开启TTS推理WebUI,稍等一会浏览器会打开一个新的推理页面。

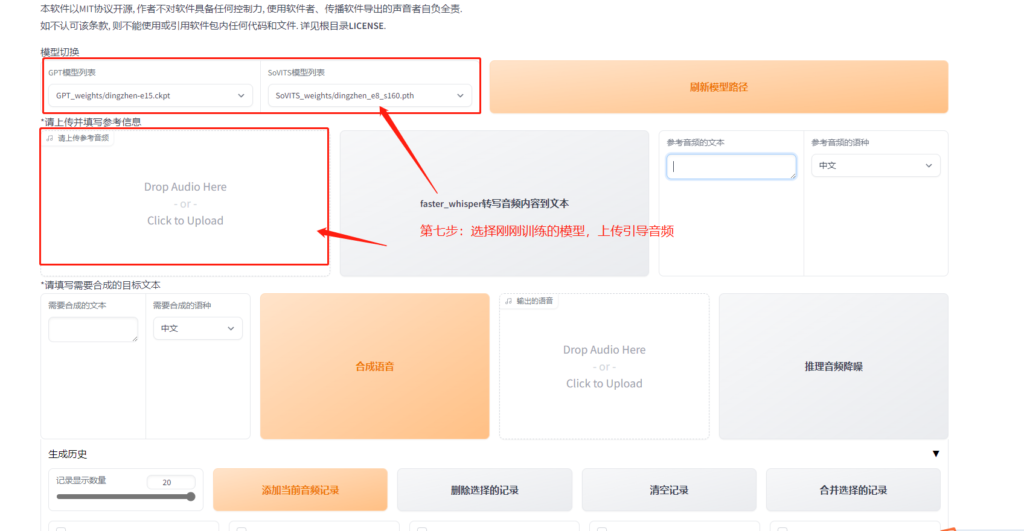

在新的页面选择刚刚训练好的模型,就是你自己起的模型名,如果模型列表没有就点击刷新模型路径

然后上传引导音频,这个引导音频其实就是情绪控制的主要途径,比如你的引导音频中人物是哭腔说话,那么你合成的语音也是哭腔,其它同理

引导音频一般在音频切片中选一条,也就是output/slicer_opt文件夹中,选择好后点击【faster_whisper转写音频内容到文本】

但它也有缺陷,比如经常吞字,莫名的停顿,这些都与训练集与引导音频有关,但相信在以后的更新中都可以解决,目前来看他克隆的效果已经近乎完美。

下面的生成历史中,可以将一小段一小段合成的音频添加到记录,最后合成一大段,做出多人对话的效果,对于视频配音非常好用。

![表情[touxiao]-淘惠啦资源网](https://www.taohuila.cn/wp-content/themes/zibll/img/smilies/touxiao.gif) 看看吧

看看吧

暂无评论内容